Uptime Kuma este un tool dragut de monitorizare, face automat rapoarte SLA, monitorizeaza site-uri, este destul de util. Pentru a monitoriza ill.ro folosesc altceva (UptimeRobot), m-am gandit sa fie independent de homelab, ca daca pica homelab-ul nu mai imi zice nimeni ca a cazut site-ul…

Voi folosi ArgoCD pentru a testa si invata cum functioneaza acest tool… l-am instalat si pana acum e doar o interfata web… Asadar sa instalam cu ArgoCD.

Pentru pasii astia avem niste prerechizite:

1. Un share nfs pentru persistent storage (il foloseste uptime kuma ca sa tina minte tot ce face)

2. Un cont de github sau orice repo, eu o sa folosesc github ca inca nu am deployat asa ceva in homelab.

3. metalLB functional 🙂

1. Mai intai share-ul NFS: am folosit v3 pentru simplitate, am permis accesul full din reteaua de acasa, desigur in afara homelab-ului vom avea autentificare si altele. Am creat un share numit uptime-kuma.

Pe nodurile k8s (control/worker) vom instala nfs-common si testam daca share-ul nfs este disponibil si putem scrie pe el.

apt install -y nfs-common

mkdir /mnt/test-nfs

mount -t nfs -o nfsvers=3 IP_NFS:/uptime-kuma /mnt/test-nfs

touch testnfs

cd /mnt/test-nfs && ls

Ar trebui sa vedem fisierul. Daca e acolo, inseamna ca nodurile noastre pot accesa NFS, trecem mai departe.

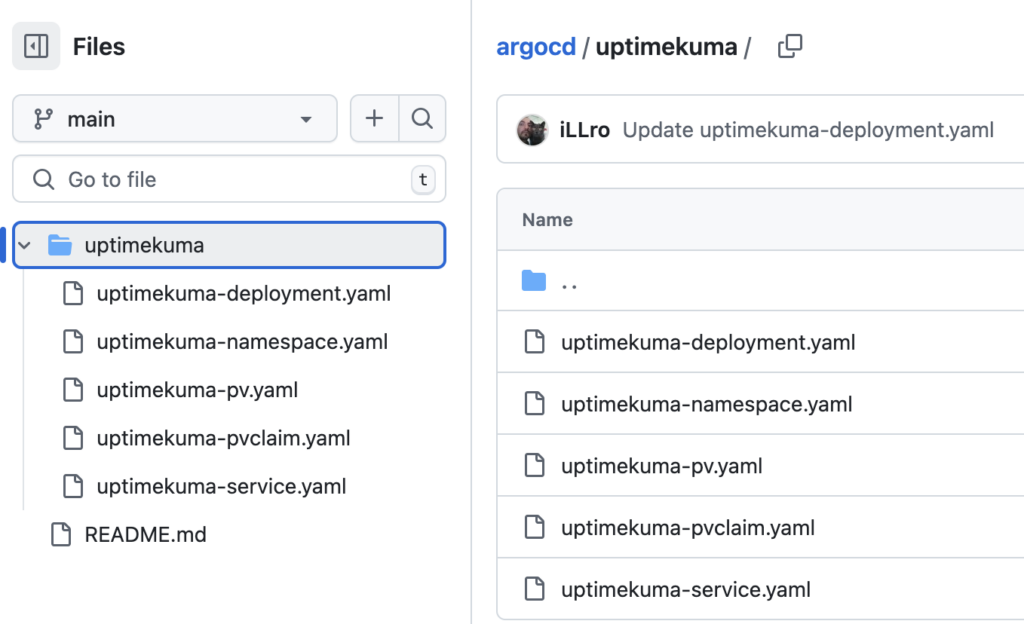

2. Github. Facem un nou repo, o sa il numesc argoCD si vom crea intr-un director nou urmatoarele fisiere:

Prima oara facem un namespace, fisierul uptimekuma-namespace.yaml.

apiVersion: v1

kind: Namespace

metadata:

name: uptime-kumaDefinim un persistent volume – uptimekuma-pv.yaml

apiVersion: v1

kind: PersistentVolume

metadata:

name: nfs-pv-uptime-kuma

spec:

capacity:

storage: 10Gi

volumeMode: Filesystem

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

storageClassName: slow

mountOptions:

- hard

- nfsvers=3

nfs:

path: /uptime-kuma

server: IP_NFS #adresa ip a serverului nfsPersistent volume claim uptimekuma-pvclaim.yaml

apiVersion: v1

kind: PersistentVolumeClaim

metadata:

name: uptime-kuma-pvc

namespace: uptime-kuma

spec:

accessModes:

- ReadWriteMany

volumeMode: Filesystem

resources:

requests:

storage: 1Gi

storageClassName: slowDefinim serviciul – uptimekuma-service.yaml

apiVersion: v1 kind: Service metadata: name: uptime-kuma-tcp namespace: uptime-kuma spec: type: LoadBalancer #nu specificam ip, lasam metallb sa aleaga pentru noi ports: - name: web-ui protocol: TCP port: 3001 targetPort: 3001 selector: app: uptime-kuma

Si in final, deployment-ul uptimekuma-deplyment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: uptime-kuma

namespace: uptime-kuma

spec:

selector:

matchLabels:

app: uptime-kuma

replicas: 1

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 1

maxUnavailable: 0

template:

metadata:

labels:

app: uptime-kuma

spec:

containers:

- name: uptime-kuma

image: louislam/uptime-kuma:1

imagePullPolicy: IfNotPresent

env:

# only need to set PUID and PGUI because of NFS server

- name: PUID

value: "1000"

- name: PGID

value: "1000"

ports:

- containerPort: 3001

name: web-ui

resources:

limits:

cpu: 200m

memory: 512Mi

requests:

cpu: 50m

memory: 128Mi

livenessProbe:

tcpSocket:

port: web-ui

initialDelaySeconds: 60

periodSeconds: 10

readinessProbe:

httpGet:

scheme: HTTP

path: /

port: web-ui

initialDelaySeconds: 30

periodSeconds: 10

volumeMounts:

- name: data

mountPath: /app/data

volumes:

- name: data

persistentVolumeClaim:

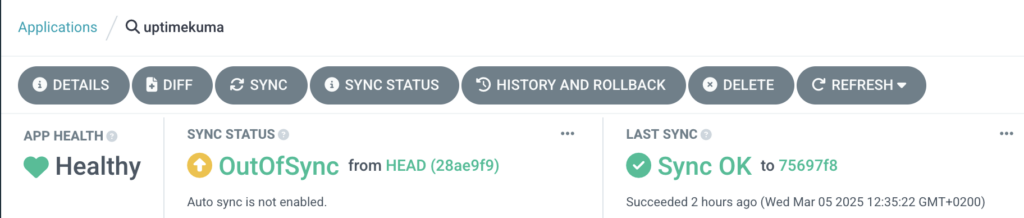

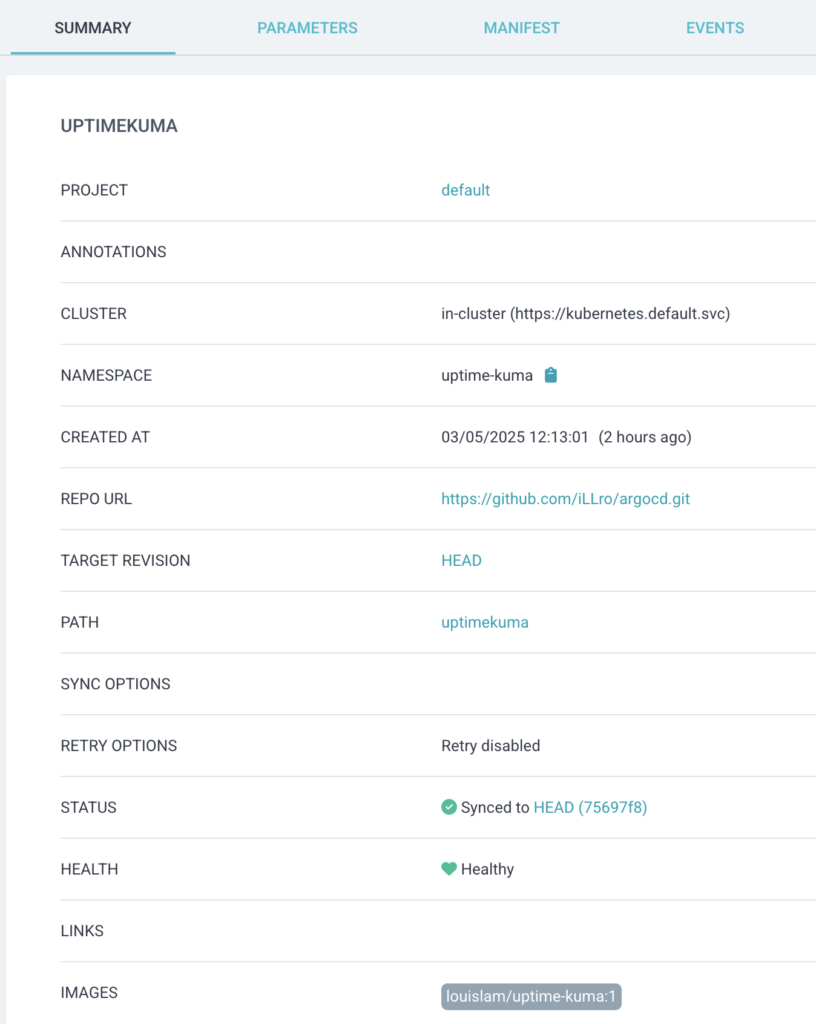

claimName: uptime-kuma-pvcPasul 2, sa intram in ArgoCD, sa definim un repository si o aplicatie. Rezultatele ar arata ca in printscreen-urile de mai jos. Avem nevoie de 2-3 lucruri:

– repository URL: tip https sau cum vreti voi, si path-ul.

– project – o sa fie default, ca nu am altceva definit

– cluster – o sa aleaga automat clusterul pe care este instalat

– path: uptimekuma – e directorul unde am pus tot.

– sync: am lasat manual

Dupa ce accesezi aplicatia si dai click pe sync, argo o sa downloadeze yaml-urile din repo, din directorul ales si o sa inceapa sa le aplice.

Rezultatul ar trebui sa arate asa:

Teoretic ar trebui sa poti accesa uptime kuma, pe ip-ul pe care il aloca metallb… si sa vezi interfata.

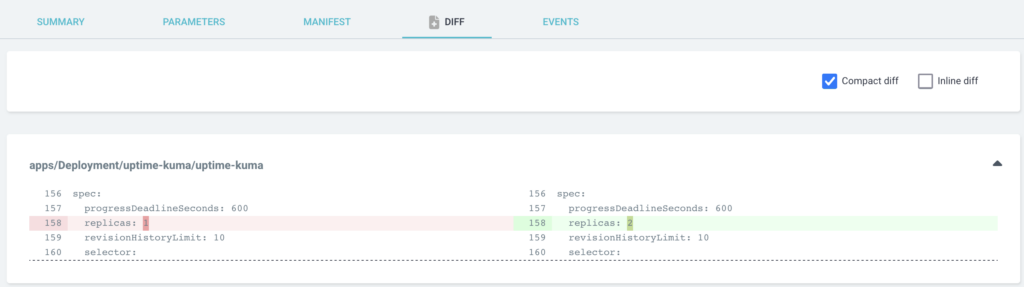

Orice schimbare a yaml-urilor din github vor fi semnalate de ArgoCD. Daca ai pus sincronizarea pe automat ar trebui ca orice modificare faci sa fie deployata in Kubernetes automat, sa zicem ca modifici numarul de replici (pod-uri) pentru aplicatia ta.. sau faci un update… Mai jos exemplu: